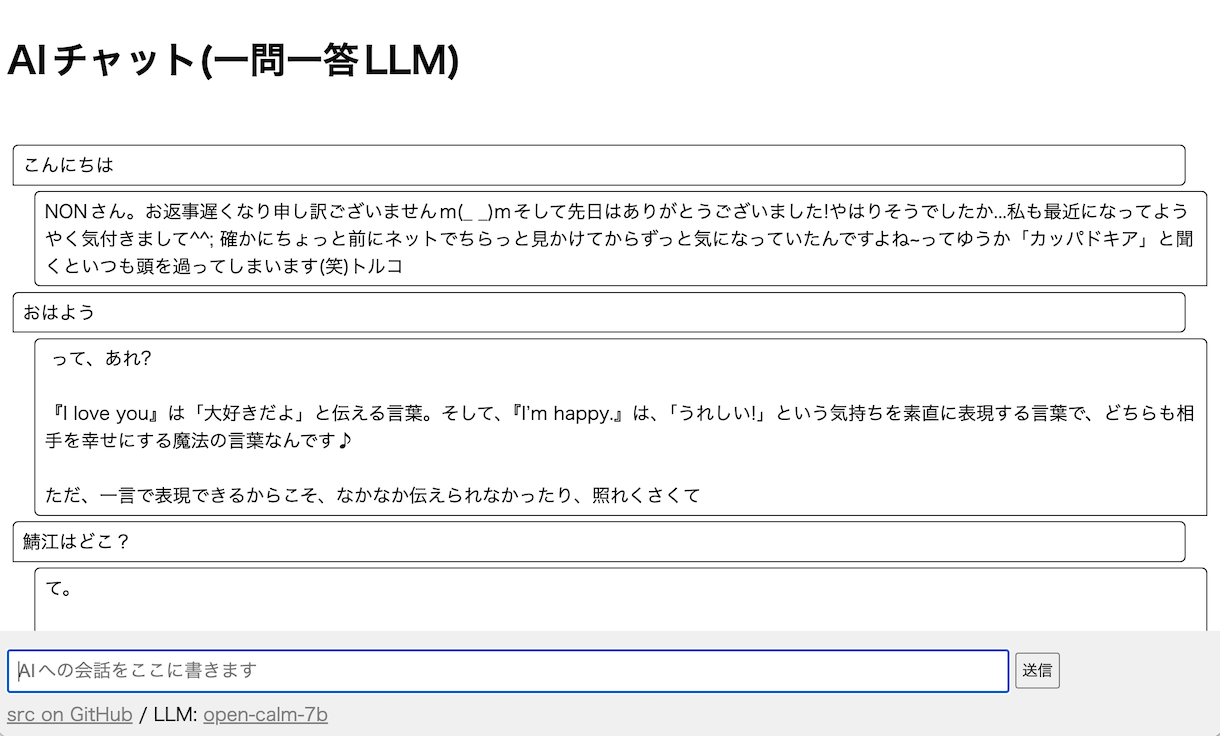

一問一答式の簡単なウェブアプリをテスト用に作りました。1年前のローカルLLMなので、回答精度はいまいちです。

BASIC認証にアクセスできる、fetchBasic.js を作成。PythonのウェブサーバーとDenoをつないでいます。

「ai_chat_lllm on GitHub」

設定方法をまとめました。ローカルLLM、いろいろと新しいものも出ているのでチャレンジしてみたい!

一問一答式の簡単なウェブアプリをテスト用に作りました。1年前のローカルLLMなので、回答精度はいまいちです。

BASIC認証にアクセスできる、fetchBasic.js を作成。PythonのウェブサーバーとDenoをつないでいます。

「ai_chat_lllm on GitHub」

設定方法をまとめました。ローカルLLM、いろいろと新しいものも出ているのでチャレンジしてみたい!