一日一創、意外と過去記事のアクセスも多いのです。

そこで、同一タグの最新記事を紹介するリンクを加えてみました。

全記事オープンデータとしています。ある程度まとまった量の記事で遊んでみたい方にもオススメです。

そこで、同一タグの最新記事を紹介するリンクを加えてみました。

全記事オープンデータとしています。ある程度まとまった量の記事で遊んでみたい方にもオススメです。

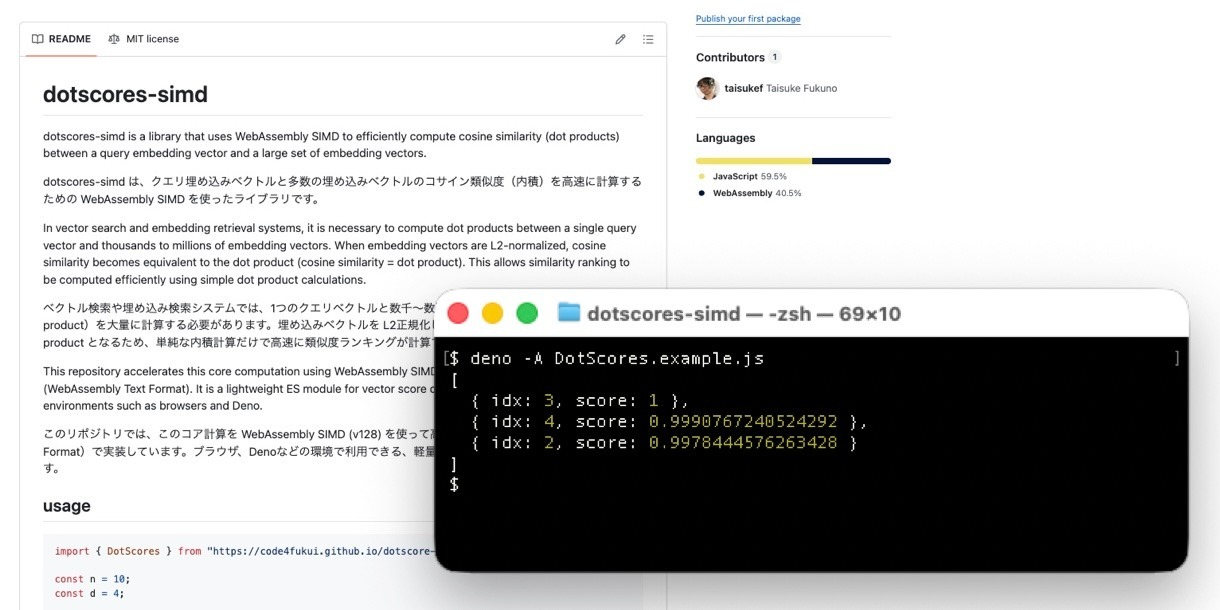

「code4fukui/dotscores-simd」

正規化したベクトル化した文章同士の比較は、内積(ドット)で計算できます。Wasm SIMDに32bit浮動小数を4つまとめて計算できて速くなるかも?

ひとまず実装ができました。

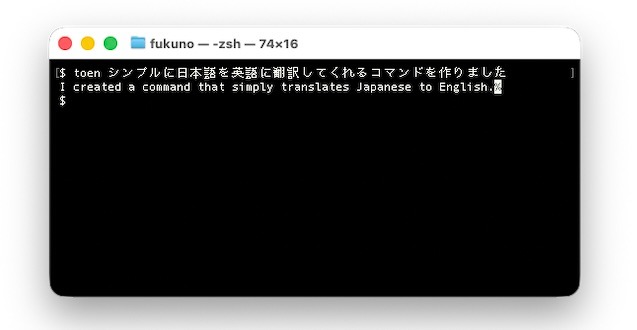

コンソールで下記のように打つだけ、インストールしておけばインターネット不要でサッと翻訳してくれます。

toen 今日はいい天気です。

未検証ですが、単語だけでなく文章もなかなかの精度で翻訳してくれそう。

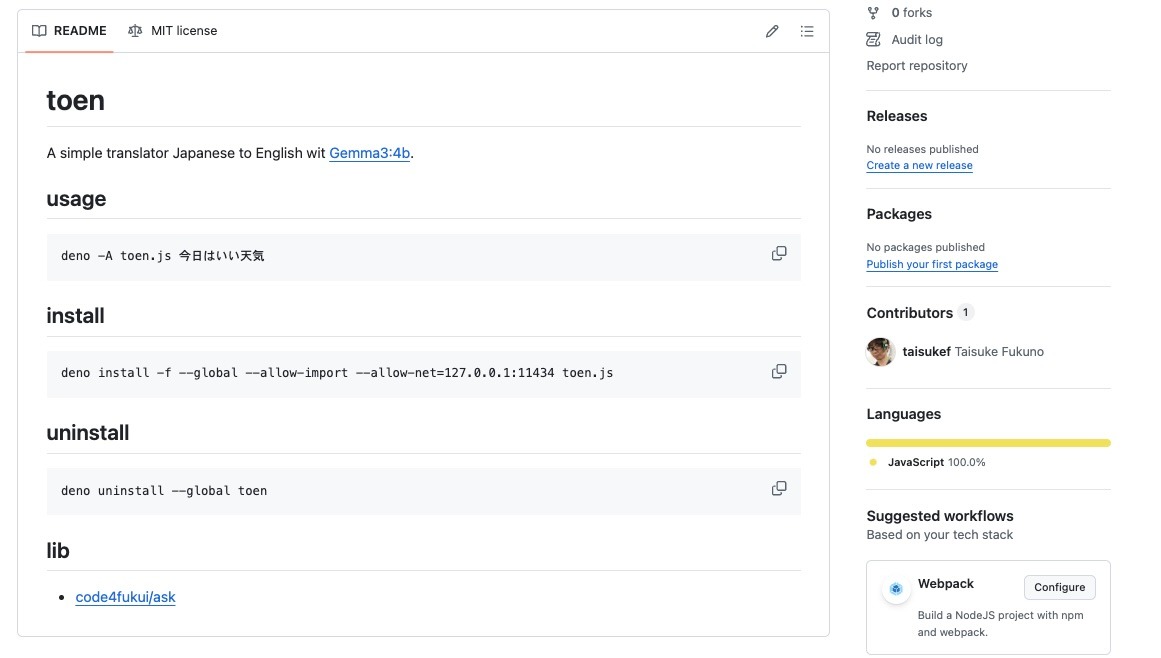

「code4fukui/toen on GitHub」

設定の仕方はこちら、GitHubをご参照ください!